基于双目的实时建图与定位研究毕业论文

2020-02-19 07:53:11

摘 要

随着计算机技术与人工智能技术的不断提升和进步,自主移动机器人得到了显著的发展。无论是在军事领域还是在工业领域或日常生活中,自动移动机器人如无人驾驶车辆,无人机和清洁机器人都被广泛使用。而自主移动机器人技术的核心问题便是解决机器人的实时建图与定位问题,机器人定位是指“Where am I?”问题,指机器人在运动过程中如何判断自己所在位置和自身姿态角度。而机器人建图便是指“What does the world looks like?”问题,即为机器人如何通过自身传感器识别标志物以及检测障碍物,从而感知周围环境。二者的精度直接决定了自主机器人在后续的路径规划中和运动控制的准确性和快速性。因此,SLAM(实时定位与建图)技术在自动移动机器人的自动化和智能化中起着至关重要的作用。随着技术的发展,SLAM技术也出现了大量的分支,可根据传感器的不同分为视觉SLAM和激光SLAM,而双目视觉SLAM系统凭借传感器简单,信息丰富等优点,在一系列实时定位与建图解决方案中脱颖而出,被大量广泛地使用。视觉SLAM系统的主要包括五大步骤,分别是传感器的信息收集,前端的视觉里程计,后端优化,回环检测以及最后的建图。本文通过对双目相机所获取的图像进行ORB特征提取与匹配,使用BA进行后端优化,实现了双目相机的实时定位与建图功能,并对双目SLAM系统中的特征提取与匹配,后端优化以及回环检测等环节进行了充分的论证与分析。

关键字:双目、视觉SLAM、自主移动机器人

Abstract

With the continuous improvement and advancement of computer technology and artificial intelligence technology, autonomous mobile robots have achieved remarkable development. Whether in the military and industrial fields, or in our daily lives, autonomous mobile robots are widely used, such as driverless cars, drones, sweeping robots, and so on. The core problem of autonomous mobile robot technology is to solve the real-time mapping and positioning problem of the robot. The robot positioning refers to the “Where am I?” question, which refers to how the robot determines its position and its own attitude during the movement. The robot mapping refers to the "What does the world looks like?" question, which is how the robot senses the surrounding environment by identifying the marker by its own sensor and detecting obstacles. The accuracy of the two directly determines the accuracy and rapidity of the autonomous robot in the subsequent path planning and motion control. Therefore, SLAM (Simultaneous Localization and Mapping) technology plays an extremely important role in the intelligentization and automation of autonomous mobile robots. With the development of technology, SLAM technology also has a large number of branches, which can be divided into visual SLAM and laser SLAM according to different sensors. The binocular vision SLAM system is based on a series of real-time positioning and construction with the advantages of simple sensor and rich information. The figure solution stands out and is widely used. The visual SLAM system consists of five major steps, namely sensor information collection, front-end visual odometer, back-end optimization, loopback detection and final mapping. In this paper, the ORB feature extraction and matching of the images acquired by the binocular camera is used, and the back-end optimization is performed by using BA. The real-time positioning and mapping function of the binocular camera is realized, and the feature extraction and matching in the binocular SLAM system is performed. Back-end optimization and loopback detection have been fully demonstrated and analyzed.

Keywords: Stereo, Visual SLAM, Autonomous Mobile Robot

目录

摘要 1

Abstract 4

第一章 绪论 6

1.1 课题研究背景与意义 6

1.2 视觉SLAM发展现状 6

1.3 本文主要研究内容 7

第二章 双目视觉SLAM系统原理 9

2.1 双目视觉测量原理 9

2.1.1 相机模型 9

2.1.2 相机畸变 10

2.1.3 双目测距原理 12

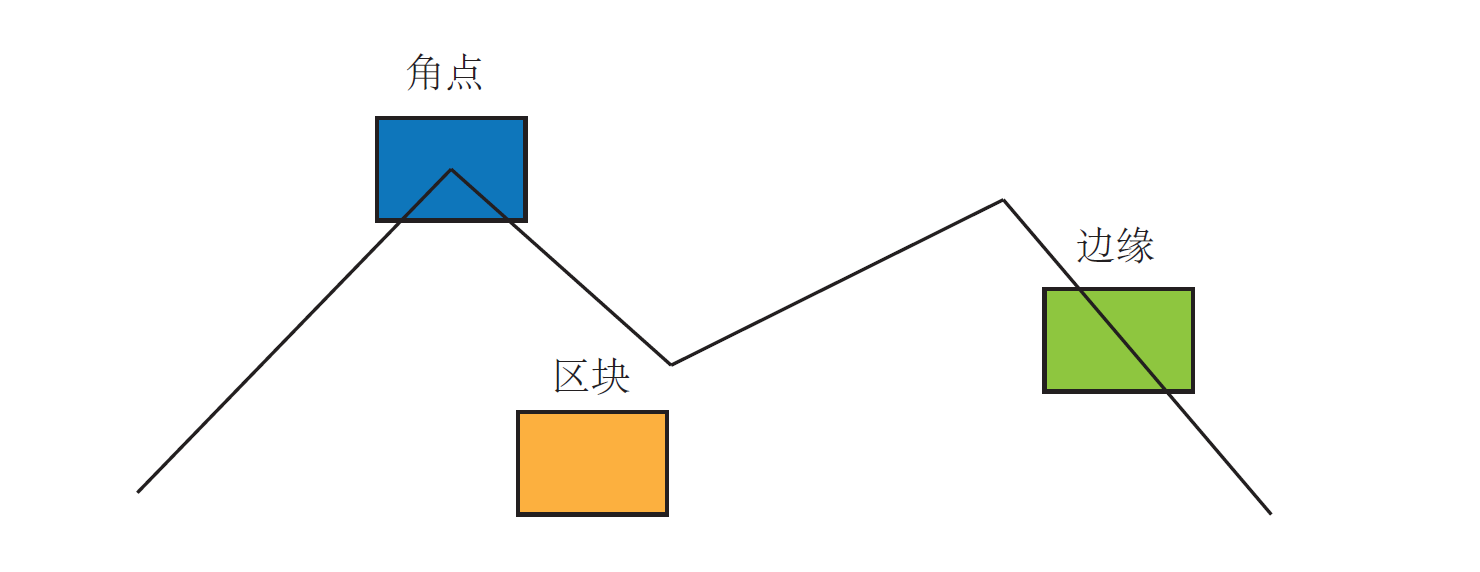

2.2 ORB特征提取和匹配原理 13

2.2.1 特征点法 13

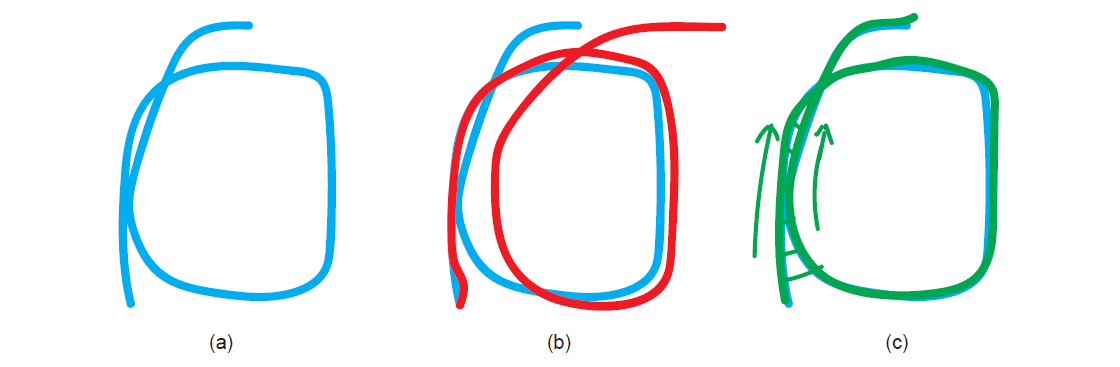

2.2.2 ORB特征提取 14

2.2.3 ORB特征匹配 17

2.3 后端优化 17

2.3.1 BA与图优化 17

2.3.2 位姿图优化 19

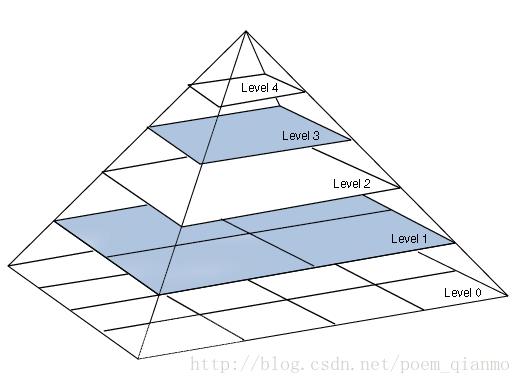

2.4 基于词袋模型的回环检测 20

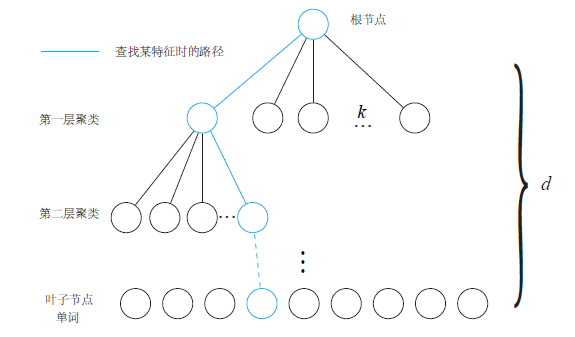

2.4.1 词袋模型 21

2.4.2 字典的构建 21

第三章 双目视觉SLAM系统实验实现 23

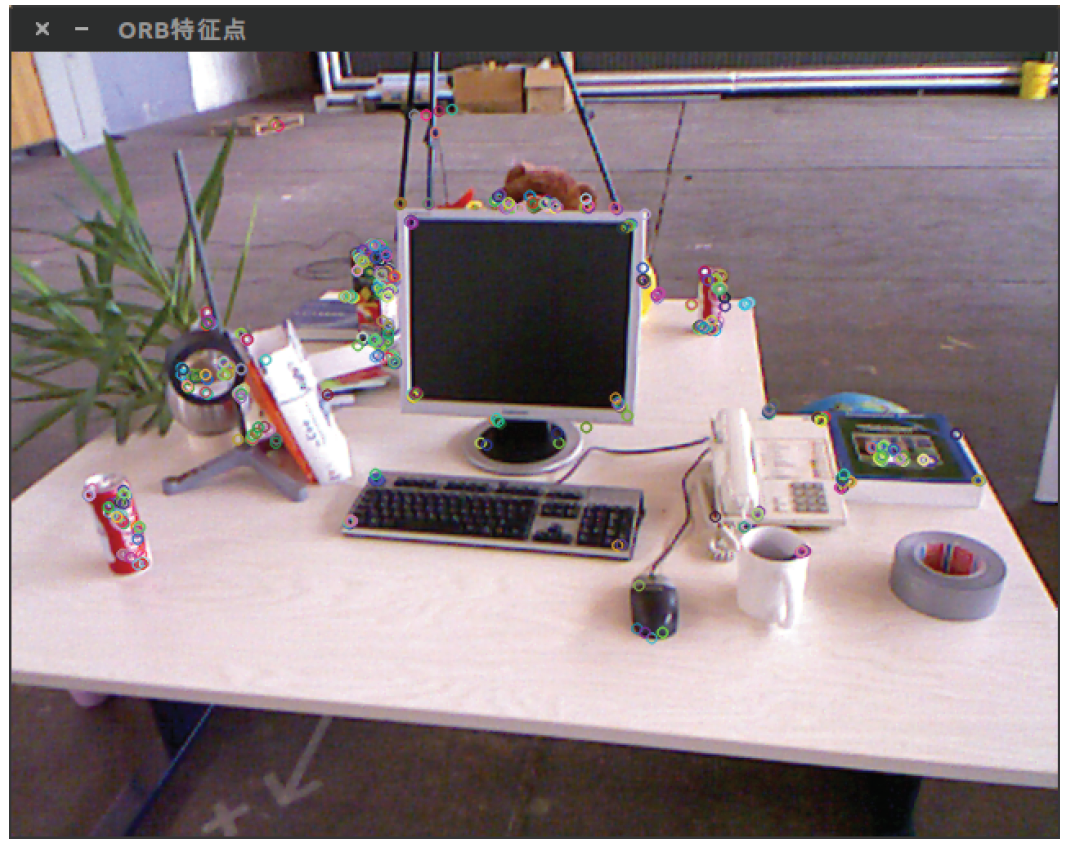

3.1 ORB特征提取与匹配实现 23

3.2 BA与位姿图优化实现 24

3.2.1 BA优化实现 24

3.2.2 位姿图优化实现 25

3.3 回环检测环节实现 27

3.4 双目视觉SLAM系统实现 27

第四章 总结与展望 31

参考文献 32

致谢 33

第1章 绪论

1.1 课题研究背景与意义

使用机器人来完成一些简单重复,或者危险的工作一直是人类追求的目标和研究的方向。早在1972年,世界上第一个移动机器人Shakey被研发出来,人类就一直没有停止研发自主移动机器人的脚步。世界上第一个移动机器人Shakey,是由查理·罗森(Charlie Rosen)领导的美国斯坦福研究所于1956-1972 年研制出来的。它首次充分利用人工智能技术,实现机器人的自动感知,环境建模,行为规划和执行任务(例如找到木箱并将其推到指定位置)。而随着科技的发展和技术的进步,自主移动机器人得到了显著的发展。在军事领域,无人机和自动扫雷机大大提高了军队的侦查效率,减低了军队侦查的危险系数;在工业领域,自动运输机为工厂减少了人力成本,显著提高了工厂的生产效率。不仅仅是军事工业领域,自主机器人的应用甚至已经进入了我们的日常生活中,例如扫地机器人、无人驾驶汽车等,人类多年对自主移动机器人走进生活的愿望也得以实现。

众所周知,自主移动机器人技术的核心问题便是“自主”二字,如何使机器人脱离人的控制自己判断所在位置和移动方向便成为所有自主移动机器人研发人员所努力的方向。虽然我们可以通过全球定位系统(GPS, Global Positioning System)和北斗卫星导航系统获得绝对位置信息,通过惯性测量系统(IMU, Inertial Measurement Unit)、轮盘编码器、电子罗盘(DC, Digital Compass)我们可以得到位姿变化信息。但是在室内或者太空中GPS和北斗系统并不能通过实时位置坐标,并且惯性测量系统等提供的位姿信息通常存在着累计误差。随着科技的发展和研发人员的探索,实时定位与建图(SLAM, Simultaneous Localization and Mapping)技术的出现渐渐代替上述描述的自主移动机器人实现方法,且逐步在自主移动机器人的智能化,自动化以及降低人工干预的计算发展过程中扮演关键角色,发挥着越来越重要的作用。

1.2 视觉SLAM发展现状

同步定位与建图(SLAM)技术是在1986年由R.C. Smith and P. Cheeseman在一项空间不确定性的表示和估计的研究中提出的。随着科技的发展,SLAM技术根据传感器的类型主要可分为使用激光雷达的激光SLAM和使用摄像机的视觉SLAM。因为相机具有成本低、体积小的优点,视觉SLAM得到了飞速的发展,且被认为是未来的主流发展方向。视觉SLAM系统可根据摄像机的数量和类型分为三种视觉SLAM系统,分别是单目视觉SLAM,双目视觉SLAM和RGB-D视觉SLAM系统。虽然单目和双目SLAM系统都是使用普通相机进行图像和视频的拍摄,但双目视觉SLAM系统是使用两个甚至多个相机进行拍摄,使用多个相机进行拍摄使双目视觉SLAM系统更加易于获取图像的深度信息。而RGB-D视觉SLAM与单目和双目视觉SLAM系统的主要区别是使用的相机类型不一样,RGB-D视觉SLAM系统是使用单目相机与红外传感器结合形成的RGB-D相机作为传感器使用。因为双目相机比单目相机有能够获取深度信息的优点,而RGB-D相机的成本造价高,双目相机相较于RGB-D相机又具有成本较低的优点,故本次毕业设计选择双目视觉SLAM作为本次课题研究方向。

双目视觉系统的提出是在上世纪的六十年代中期,由美国麻省理工大学的Roberts教授提出的。他是通过从数字图像中提取立体图形的三维结构,把过去的简单二维图像分析推广到了复杂的三维场景,这一项研究的成功标志着双目视觉技术的诞生。随着几十年的发展,国内外对双目视觉系统的研究和开发都有了显著性的进步,例如将双目视觉应用于伺服系统,将双目视觉与增强现实(AR)计算结合,以及将双目视觉技术应用于智能交通设计领域等等。而双目视觉系统在实时定位与建图领域方面也有广泛的应用。 因为双目相机的结构优势使得双目视觉系统能快速得到图像中的深度信息,从而使得搭建双目视觉SLAM系统时能够更加快捷方便地对图像进行处理分析。

1.3 本文主要研究内容

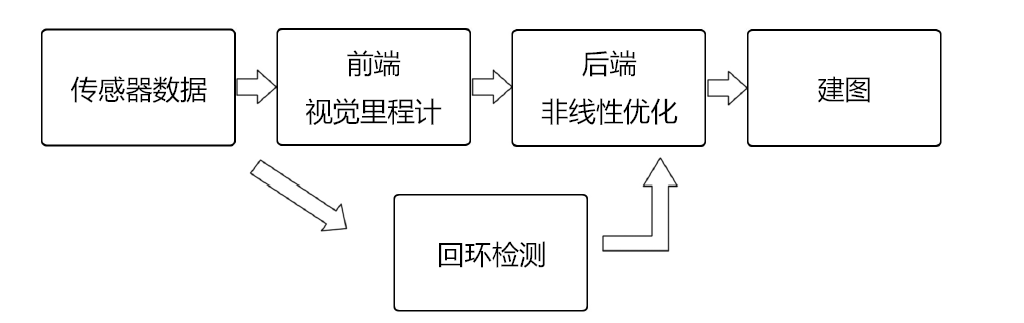

双目视觉SLAM系统主要由三个部分组成,分别是前端视觉里程计,后端优化和回环检测,系统的组成结构如下图所示。

|

图1.1 视觉SLAM系统结构 |

本文对三个部分进行了详尽的研究和分析,并通过实验完成了双目视觉SLAM的实时定位与建图功能,具体内容简述如下:

前端视觉里程计的主要功能是通过相邻图像的信息差别,从而分析出两张图像之间的运动关系,从而得到相机运动。通过使用视觉里程计估计两张图像相机的运动后,将相邻时刻的相机运动进行串联,就可以得到机器人的运动轨迹了;而另一方面,我们可以根据每个时刻相机的位置,将每个时刻各像素空间点的位置计算出来,我们就可以得到地图。但因为视觉里程计每次估计相邻两个图像的相机移动时必定会产生误差,而经过一段时间大量图像处理后不可避免地会出现累计漂移的问题,因此后端优化和回环检测环节在双目视觉SLAM系统中是不可或缺的。

后端优化模块是用于消除机器人在长时间运动后轨迹和地图不可避免地产生的累计误差。后端优化环节主要是通过将相机在运动过程中的误差转换为最下二乘估计,并用非线性方法解决,从而得到长时间内的最优轨迹和地图。本文的优化主要分为局部优化和全局优化两部分。局部优化旨在优化跟踪过程中的局部误差,使用BA优化实现相关功能。而全局优化与回环检测相结合,简化BA优化,仅通过位姿图优化摄像机轨迹。

前文介绍的前两个部分是关于前端和后端,前端负责特征点的提取和匹配,根据提取到的特征点匹配后得到相机轨迹、地图的初值,而后端环节主要功能是对前端得到的初始数据进行优化。然而仅仅通过前端和后端,我们进考虑了相邻时间上的关联,累计误差还是存在,我们依然无法得到全局一致的轨迹和地图。而回环检测环节能给给出相邻帧以外相隔更久远的约束,使整个系统能实现去全局一致性。回环检测为我们的双目视觉SLAM系统带来了两方面的提升和优化:回环检测环节一方面提高了双目视觉SLAM系统中的轨迹和地图的估计准确性,而另一方面,回环检测环节同时也将系统中的当前数据与历史数据进行了关联,通过将长时间的数据关联,系统可以实现在相机跟踪丢失后通过回环检测环节读取历史数据,从而实现相机的重定位。

第2章 双目视觉SLAM系统原理

2.1 双目视觉测量原理

我们在现实生活中能看到大量的照片。在计算机中所有的图像都是由成百上千的像素组成,每个像素保存的都是该像素的色彩或者亮度信息。那像素是怎么形成的呢?我们现实三维世界的物体通过反射太阳光或作为光源发射出来的光通过光学相机的中心投射到相机成像面上,成像平面上中的光敏元件便可以接收到光以获得光颜色信息和光亮度信息,从而得到我们看到图片的像素。本节主要介绍的内容便是相机模型,相机畸变以及双目视觉SLAM中最重要的双目相机的测距原理。

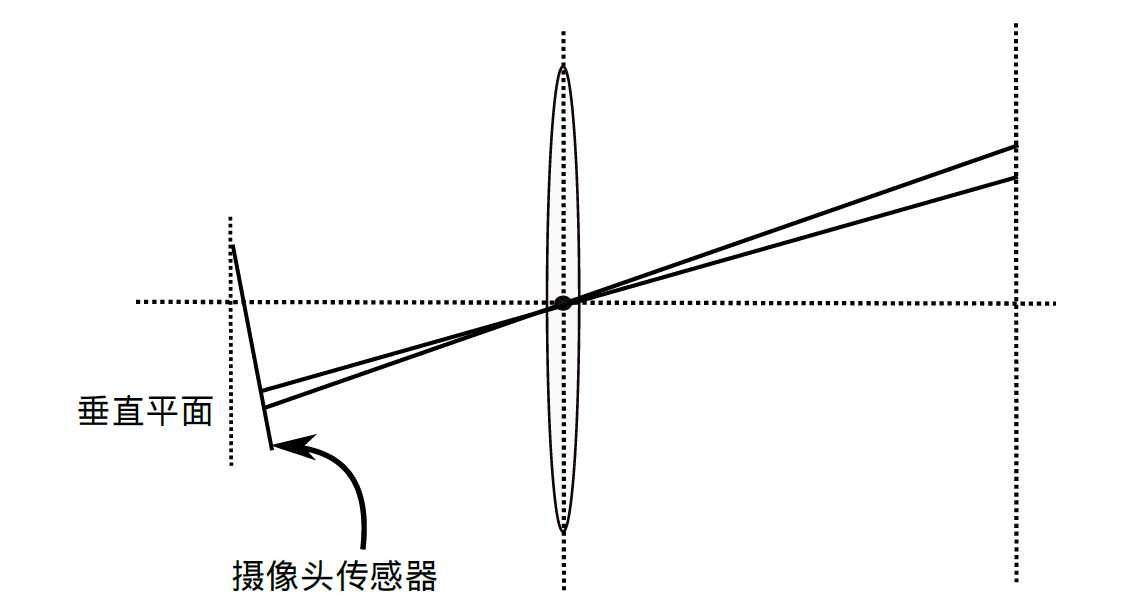

2.1.1 相机模型

众所周知,我们的世界是三维的,而相机拍摄照片便是将三维世界中的坐标点映射到二维图像平面(单位:像素)。相机将现实世界3D坐标系中的点映射到到2D平面的过程我们便可称为相机模型,下图显示了相机模型中最简单的针孔相机模型。

|

图2.1 针孔相机模型 |

根据图2.1我们可以将针孔相机模型进行建模,设为相机坐标系(其中O点为相机光心),现实三维空间中的P点经过相机的光心O后映射在成像平面上,映射点为。若设P点坐标为,的坐标为,焦距为ƒ,可得:

(2.1) |

等式中负号表示成像倒立,为方便计算可简化为:

(2.2) |

整理可得:

(2.3) |

式(2.3)描述了点P和它的相机成像之间的空间关系。但仅通过上述表达式我们并不能转换至图像平面中进行计算,因为在图像平面中,我们的单位是一个个像素,因此我们需要在成像平面上对图像进行采样和量化。为了描述传感器将感受到的光线转换成图像像素的过程,我们设在物理成像平面上固定着一个像素坐标系o-u-v,我们便可以在像素平面得到的像素坐标。设像素坐标在u轴缩小倍,在v轴上缩小倍,且原点平移,的坐标与像素坐标关系即为:

(2.4) |

将式(2.4)带入(2.3)中且将用带替,并把式子写成矩阵形式:

(2.5) |

式(2.5)中中间量矩阵被称为内参数矩阵K。通常认为,相机的内参在出厂之后是固定的,不会在使用过程中发生变化。除内参以外,外参也是存在的。因为相机在拍摄时在不断地运动,相机存在旋转和平移,故我们可以用表示P点的世界坐标,用旋转矩阵R和平移向量t表示P点的移动:

(2.6) |

简化后即为:

(2.7) |

式(2.7)中的旋转矩阵R和平移向量t即为相机的外参数。相比于内参,相机的外参会随着相机变化而变化,相机外参即为视觉SLAM中最核心的待估计量,通过R和t我们便能求出相机运动的轨迹。

2.1.2 相机畸变

现实生活中我们的相机并不是简单的小孔成像,为了摄像效果,相机前方都安装了透镜。加入透镜后光的传播轨迹发生了变化,从而使相机成像的位置也发生了改变,我们将这些因为透镜加入产生的成像位置改变称为畸变。畸变分为两种类型,分别为径向畸变和切向畸变

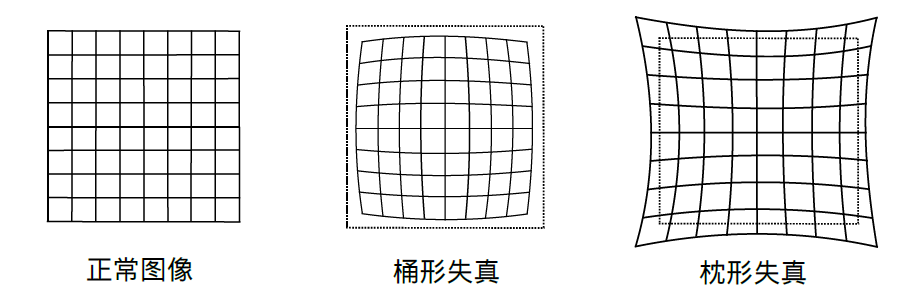

径向畸变一般是由于透镜自身形状改变了光线的传播,导致现实世界的直线变成了曲线。径向畸变主要分为两类,桶形畸变和枕形畸变,二者如图所示。

|

图2.2 径向畸变两种类型 |

除了透镜的形状会引入径向畸变外,在相机的组装过程中由于不能使得透镜和成像面严格平行也会引入切向畸变。如下图所示。

|

图2.3 切向畸变示意图 |

径向畸变中,桶形畸变和枕形畸变都是与距中心距离成正比,故可用与中心距离有关的高次多项式函数进行纠正:

(2.8) |

对于切向畸变,我们可以用参数来纠正:

(2.9) |

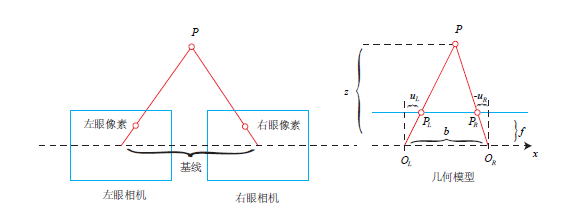

2.1.3 双目测距原理

单个相机只能为我们提供三维世界物体在二维平面的一个像素,而通过单个像素是无法确定该物体在三维世界的具体位置。这是因为从相机光心O和物体P连线上的所有点,都会投射到像素平面中的一个像素上。只有当物体P和相机光心O之间的距离(即像素深度)确定,我们才能确切地得到物体在三维世界的具体位置。

其实仔细观察生活,我们就会发现,人眼带给我们大脑的不仅仅是平面信息,而是可以直观地告诉我们眼前的问题在三维空间的具体位置和距离,人类的双眼其实就可以测量像素深度。人眼是通过左眼和右眼看到的物体差异来判断物体和我们之间的距离的,双目相机也是如此。双目相机也是通过左摄像头和右摄像头之间收集到的同时刻图像信息差异

以上是毕业论文大纲或资料介绍,该课题完整毕业论文、开题报告、任务书、程序设计、图纸设计等资料请添加微信获取,微信号:bysjorg。

相关图片展示: