在谈判型对话中解耦策略学习与语句生成外文翻译资料

2021-12-28 22:58:48

在谈判型对话中解耦策略学习与语句生成

He He,Derek Chen,Anusha Balakrishnan,Percy Liang

斯坦福大学计算机系

摘要

我们考虑一种两个代理人使用自然语言根据货物进行讨价还价的谈判场景。代理商需要同时决定高层次的策略(例如,要价50美元)和该策略的执行(例如,生成“自行车是全新的,只卖50美元!”)。近期有不少关于谈判模型的训练研究成果,但它们的端到端属性让他们很难控制自己的策略,而强化学习倾向于较低标准的解决方案。在本文中,我们提出了一种基于简略对话行为的模块化方法(例如,建议(价格= 50)),将策略和生成两部分进行分离。我们展示了我们可以使用有监督的学习,强化学习或者特定于领域的知识灵活地设定策略而不用降低标准,而我们基于检索的生成可以保持情境意识并产生多样化的话语。我们在最近提出的DEALORNODEAL游戏上测试了我们的方法,我们还基于Craigslist上的真实物品收集了一个更丰富的数据集。真人评估表明我们的系统实现了更高的任务成功率以及更像人类的谈判行为。

1 引言

一个好的谈判者需要决定实现某个目标的策略(例如,要价$ 6000)并通过生成自然语言来实现该策略(例如,“我真的需要一个汽车,所以我可以去上班,但我只有6000,再多的话我可能连孩子都养不活了。”)。过去NLP中大部分关于谈判的研究重点关注的策略(对话管理)要么是不含自然语言(Cuayahuitl等,2015; Cao等,2018),要么是封装好的回答(Keiser等,2017年;Traum等2008)。 最近,端到端神经模型(Lewis等,2017; He等,2017)用于同时学习人与人对话中的对话策略和语言生成,符合在目标导向型对话和开放领域对话中使用神经网络模型的趋势。然而,这些模型存在两个问题:(i)难以控制和解析策略,(ii)通过强化学习直接优化代理人的目标通常会导致过于简单的解决方案:话语变得不合理(Lewis 等,2017)或 出现重复(Li 等,2016)。

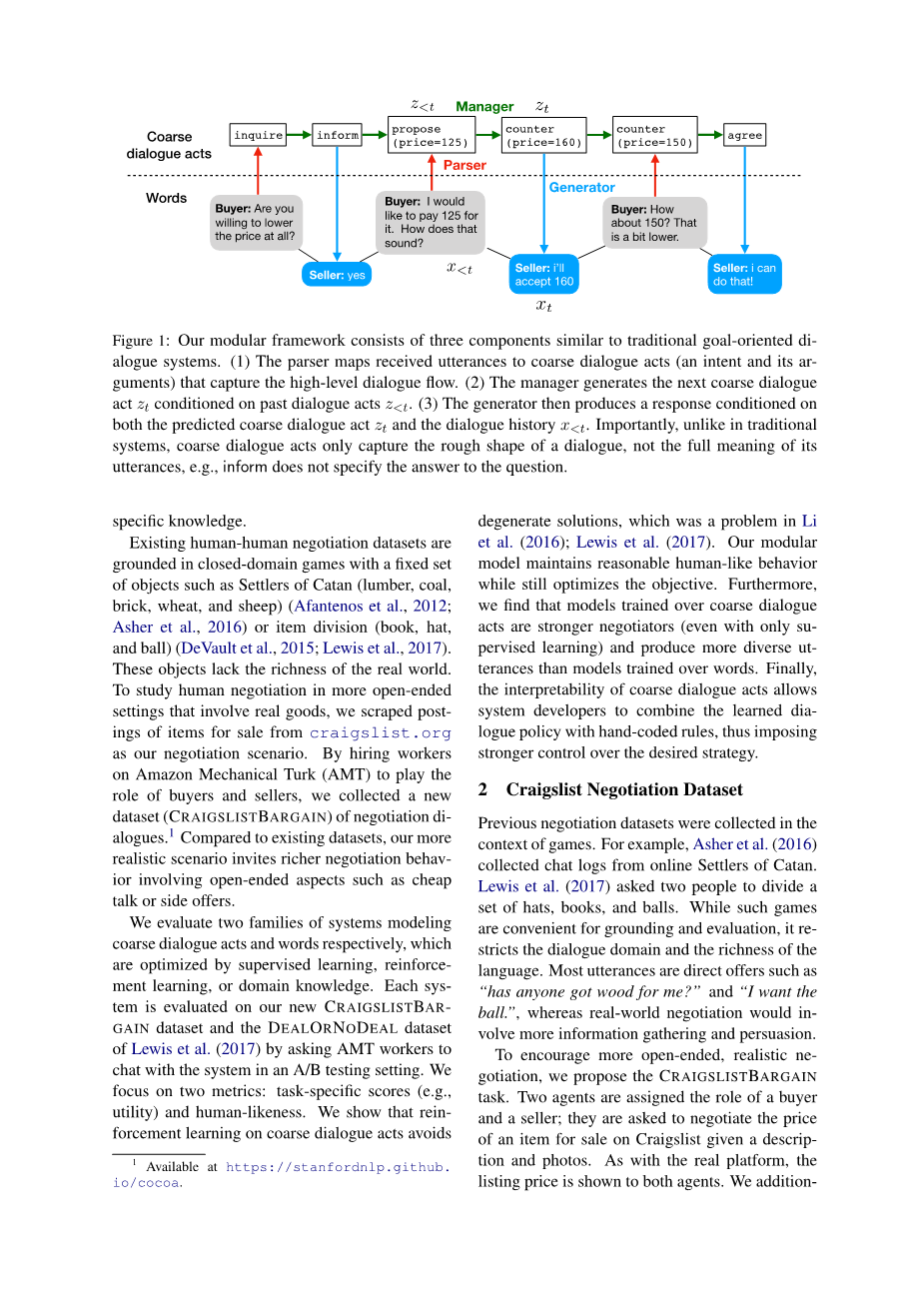

为了解决这些问题,我们的主要思想是将策略构建和语言生成分离,这使我们能够控制策略,以便我们可以使用相同的语言生成器实现不同的协商目标(例如,最大化实用性,实现公平交易)。 我们的框架由图1中所示的三个组件组成:首先,解析器识别关键字和实体,以将每个话语映射到捕获高层级策略变化的简略对话行为。 然后,对话管理器将基于从解析的训练对话中学习的简略对话行为的序列到序列模型来响应对话行为。最后,在给定对话行为和对话历史的情况下,语言生成器将产生相应的对话语句。

我们的框架遵循传统的以目标为导向的对话系统(Young等,2013),其中一个重要区别是:粗略的对话行为无意也无法捕获话语的全部含义。由于谈判对话是相当开放的,因此生成器需要依赖于完整的话语历史。 例如,考虑图1中的第一轮对话。我们无法仅根据当前对话行为生成回答,我们还必须看看上一个问题。但是,我们仍然使用监督学习,强化学习或特定领域的知识来优化粗对话行为空间中的对话管理器。

现有的真人协商数据集以封闭域游戏为基础,这些游戏一般具有一组固定的对象,例如卡坦定居者(木材,煤炭,砖,小麦和绵羊)(Afantenos等,2012;Asher 等,2016)或相互独立的东西(书籍,帽子和球)(DeVault等,2015; Lewis等,2017)。这些对象缺乏现实世界的丰富性。研究人类谈判的更多涉及真实商品的开放式问答,我们从craigslist.org中爬取了待售商品的贴子作为我们的谈判场景。 通过雇用AMT上的工人扮演买家和卖家的角色,我们收集了一个新的谈判对话数据集(CRAIGSLISTBARGAIN),与现有数据集相比,我们拥有更多的现实场景,并引入了更丰富的开放式谈判行为,如廉价磋商或提供优惠。

我们分别评估两个系统建模粗对话行为和单词,这些系统通过监督学习,强化学习或领域知识进行优化。每个系统都在我们新的CRAIGSLISTBARGAIN数据集和Lewis等人的DEALORNODEAL数据集上进行评估。通过要求AMT工作人员在一个A/B测试设置中与系统聊天。我们关注两个指标:任务特定的分数(例如,效用)和与人类的相似度。我们表明,简略对话行为的强化学习可以避免次一级的解决方案,这在Li和Lewis等人的研究中是一大问题。我们的模块化模型保持了合理的人类行为同时仍然会优化目标。此外,我们发现,通过简略对话行为训练的模型是更强大的谈判者(即使只通过有监督的学习),并且比训练过的文字模型产生更多样化的语句。最后,粗对话行为的可解释性允许系统开发人员将学习的对话策略与手动编码规则相结合,从而对所需策略施加更强的控制。

2 Craigslist谈判数据集

先前的谈判数据集是在游戏的上下文中收集的。 例如,Asher等人。 (2016)从在线Settlers of Catan收集聊天记录。 刘易斯等人的研究中要求两个人分开一套帽子,书籍和球。虽然这些游戏便于基础和评估,但它限制了对话领域和语言的丰富性。大多数言论都是直接的提议,例如“有人为我买木头吗?”和“我想要球”,而现实世界的谈判将涉及更多的信息收集和劝说。

为了鼓励更开放,更现实的谈判,我们提出了CRAIGSLISTBARGAIN任务。 两个代理人被分配了买方和卖方的角色; 根据描述和照片,他们被要求在Craigslist上协商待售商品的价格。 与真实平台一样,向两个代理商显示上市价格。我们还将为买方建议一个私人价位作为目标。代理交替轮流聊天。 代理可以随时输入提供的价格,合作伙伴可以接受或拒绝。代理也可以选择退出,在这种情况下,任务完成但双方没有达成一致。

为了生成谈判方案,我们从6个最受欢迎的类别(住房,家具,汽车,自行车,电话和电子产品)中删除了sfbay.craigslist.org上的帖子。每个帖子产生三种场景,其中买方的目标价格为上市价格的0.5倍,0.7倍和0.9倍。 场景统计如表2所示。

我们使用附录A图2中显示的界面在AMT上收集了6682个真人对话。表3中的数据集统计显示,与先前的数据集相比,CRAIGSLISTBARGAIN具有更长的对话,语言更加多样化。此外,我们鼓励众包人员强化该项目并协商诸如免费送货或提货等方面的要求。这种高度相关的情景导致了更丰富的对话,如表1所示。我们还观察到表4中列出的各种说服技巧,例如装饰,单边报价,以及表达同情。

3 具体方法

3.1 动机

虽然端到端神经模型在对话系统方面取得了令人振奋的进展(Wen等,2017a; Dhingra等,2017),但我们发现他们很难同时学习在CRAIGSLISTBARGAIN中取得成功所需的策略和丰富的话语。例如,表8(a)显示了人类和基于序列到序列的机器人之间的典型对话,其中机器人很容易就表示同意。我们现在希望将谈判策略和语言生成分开。假设买方说:“我觉得对于一部用了10年的老电视机来说275有点高。你能降价吗?150怎么样?”我们可以通过提出粗略的对话行为(价格= 150)捕获最重要的信息。然后,为了生成对卖方的回答,代理可以首先关注这种粗略的对话行为,而不是必须同时摄取自由形式的文本。一旦确定了对方的价格,剩下的就是互相要价的开放式对话,例如,尽管电视用了很多年,但仍强调它的质量。

受这些观察的启发,我们现在描绘出一个模块化框架,它能从话语中提取简略的对话行为,学会优化对话行为空间中的策略,并基于完整的对话历史使用检索来填充开放式对话中的关键部分。

3.2 概览

我们的目标是建立一个对话代理机器人,它利用对话历史,即一系列话语x1hellip;xt-1与对话场景c(例如,项目描述)一起,并生成关于回答xt的分布。对于每个话语xt(例如,“我愿意支付15美元”),我们定义简略对话行为zt(例如,建议(价格= 15));简略对话行为充当逻辑框架而并不会捕获话语的完整语义。遵循传统的面向目标的对话系统(Young等,2013)的策略,我们根据以下三个模块广泛地定义了我们的模型:

1. 解析器。在给定对话历史xlt;t和zlt;t,以及场景c的情况下,(确定性地)将输入话语xt-1映射到简略对话行为zt-1上。

2.管理器。基于过去的简略对话行为z lt;t和情景c,预测回应对话行为。

3. 生成器。在给定完整对话历史x lt;t的情况下,将简略对话行为zt转换为自然语言回答xt。

由于简略对话行为不能捕获完整的语义,因此解析器和生成器将保持对对话历史的持续访问。主要的限制是代理检查对话行为,正如我们将在第4.4节展示的一样,会降低在强化学习期间系统退化的风险。 我们现在详细介绍下每个模块(图1)。

3.3解析器

我们的框架以简略对话行为z为中心,其中包含一个意图和一组参数。 例如,“我愿意支付15美元”被映射到 建议(价格=15)。 我们的简略对话行为不打算捕获句子的完整语义这一事实让我们得以使用简单的基于规则的解析器。它通过正则表达式匹配和一些if-then规则来检测意图和它的参数。我们的解析器从检测实体(例如,价格,对象)和匹配关键字模式(例如,“降低”)开始进行工作。根据有序的规则列表检查这些信号,我们在多个匹配的情况下选择第一个匹配的意图。 如果未触发规则,则输出未知行为。 使用的意图解析规则列表如表5所示。请参阅附录B,了解基于实体检测的参数解析。

3.4 管理器

对话管理器决定对话代理在给定过去的顺序zlt;t和方案c每个时间步t应采取的动作。下面,我们描述了三种方法来学习对话管理器,增加可控性:在训练语料库(监督学习)中建模人类行为,明确优化奖励功能(强化学习),以及注入手工编码规则(混合策略)

监督学习。给定解析的训练语料库,每个训练示例是在一个对话的一系列简略对话行为,z1hellip;zt。我们通过最大化训练数据的可能性来学习转移概率ptheta;(zt| zlt;t,c)。

我们使用标准的序列到序列模型。每个简略对话动作表示为一系列符号,即其每个参数后面的意图,例如“要价150”。 在代理人的倾听过程中,LSTM对收到的简略对话行为进行编码; 在演讲期间,另一个LSTM在简略对话行为中对符号进行解码。 隐藏的状态在整个对话中传递,以提供完整的历史记录。

简略对话行为的词汇量远小于单词量。例如,我们的实现包括少于10个意图和参数值被归一化和分箱(参见第4.2节)。

强化学习。 有监督的学习旨在模仿人类的平均行为,但有时我们希望直接针对特定的对话目标进行优化。 在强化学习中,我们在简略对话行为的整个序列上定义奖励R(z1:T)。具体来说,我们尝试了三种奖励函数:

效用是自利代理人的目标。 对于CRAIGSLISTBARGAIN,我们将效用函数设置为最终价格的线性函数,这样在价格为目标价格时买方效用为1,在价格为售卖价格时卖家效用为1,在价格为售卖价格和买方目标价格的中点时双方效用为零,使其成为零和游戏。对于DEALORNODEAL,效用是给予代理的对象的总价值。

公平旨在实现双方结果的平等,即消除双方效用之间的差异。

长度是对话中话语的数量,以此来鼓励双方尽可能长时间地聊天。

如果未达成协议,奖励为-1。

我们使用策略梯度(Williams,1992)进行优化。给定采样轨迹z1:T和最终奖励r,令ai为沿轨迹的第i个生成的符号(即,根据对应策略采取的“动作”)。 我们以如下方式更新参数theta;:

其中,eta;是学习率,b是到目前为止的方差减少估计的基线。

混合策略。 鉴于可解释的简略对话行为,一个简单的选择是编写具有领域知识的基于规则的管理器,例如,如果zt-1 = greet,则zt = greet。 我们将这些规则与训练好的管理器结合起来,以微调对话策略。 具体地,对话管理器根据学习好的序列模型预测意图,但使用规则填充参数(例如,价格)。 例如,给定预测的预期价格,我们可以将价格设置为买方和卖方目前预期价格的平均值(差异分割策略)。

3.5 生成器

我们使用一个基于简略对话和对话历史的检索生成器。我们的数据库中用于检索的每个候选者都是一个话语xt及其对话上下文xt-1的元组,由模板和简略对话行为表示。 即(d(xt-1),zt-1 ,d(xt),zt),其中d是模板提取器。具体而言,给定解析的训练集,通过在其简略对话行为中对论证进行去异化来将每个话语转换为模板。 例如,“150美元如何?”会变成“ [价格] 如何?”,其中[价格]是在生成时会被填充的占位符。

在测试时,给定来自对话管理器的zt

英语原文共 13 页,支付完成后下载完整资料

资料编号:[3150]